Contribution à la réflexion du Plan Bâtiment Durable

1. Quels sont les éléments déclencheurs et les freins à la réalisation par les propriétaires et les locataires de travaux de rénovation ?

1.1. Eléments déclencheurs

Les éléments déclencheurs pour entreprendre des travaux de rénovation sont l’obligation et l’envie.

L’obligation peut résulter d’une nouvelle contrainte réglementaire (Réglementation Thermique, obligation de travaux…), d’une dégradation physique du bien, de son obsolescence (réglementaire ou technologique) ou encore d’une inadaptation du bien à son usage (nouveaux usages, recomposition familiale, vieillissement, handicap, dépendance…)

L’envie de faire des travaux de rénovation répond à deux stimuli qui différent par l’intention mais qui conduisent au même résultat: le désir de valoriser son bien et celui de l’améliorer. On trouve dans cette catégorie les opérations d’amélioration du confort, de l’esthétisme, de l’image et de la performance énergétique du bien.

Le propriétaire occupant comme le propriétaire bailleur sont intéressés par l’ensemble des sujets, le propriétaire bailleur étant particulièrement intéressé par la capacité de son bien à être loué et à être vendu. Les actions de rénovation qu’il entreprendra dépendront exclusivement de ce critère. A ce titre l’amélioration de la performance énergétique ne sera un élément déclencheur de la rénovation qu’en zone détendue.

Le locataire, quant à lui, ne pourra obtenir des travaux de rénovation de son propriétaire que dans le cas de non-respect à une obligation règlementaire et de dégradation physique du bien qu’il loue.

1.2 Freins

Les freins à la rénovation des logements sont liés à la capacité de financement des travaux et à l’absence d’envie de les réaliser.

Le financement est le problème majeur. Même si, aujourd’hui, l’argent est abondant et peu cher, il n’en n’est pas moins qu’un prêt à taux faible n’a d’intérêt que pour ceux qui ont déjà quelques moyens. Pour les autres, un prêt, à taux faible ou même nul, demandera toujours à être remboursé ce qui posera un problème quand l’argent manque déjà. Quant aux crédits d’impôts, ils ne concernent que les foyers ayant suffisamment de revenus pour être imposables.

Le deuxième frein, essentiel, est l’absence d’envie. S’agissant en particulier de faire des économies d’énergies, l’avantage espéré (baisse de la facture de l’énergie) paraît bien faible en regard des inconvénients réels ou supposés: absence de preuve de l’atteinte du résultat, défaut temporaire de pleine jouissance du bien (pendant les travaux), risques de dégradations collatérales (détériorations, salissures), baisse de confort (diminution de l’éclairage et de la ventilation naturels, fermeture de balcons et de loggias…) et de valeur (diminution de la surface dans le cas de l’isolation par l’intérieur).

Enfin, pour mener des travaux, si on a l’argent et l’envie, encore faut-il avoir le temps et la compétence pour le faire.

Autant dire qu’aujourd’hui, en l’absence d’obligation réglementaire, les freins sont malheureusement plus nombreux que les éléments déclencheurs, ce qui explique sans doute pourquoi la rénovation des logements et en particulier la rénovation énergétique n’a toujours pas vraiment décollé.

2. Quels sont les différents angles d’approche pour encourager le passage à l’acte de la rénovation de l’habitat ? Lorsque l’on parle de confort, quelles sont les différentes définitions à prendre en compte ? Quelle temporalité ? (Vieillissement de la population)

2.1 Angles d’approche

Les angles d’approche pour encourager le passage à l’acte de la rénovation de l’habitat dépendent des éléments déclencheurs de la rénovation.

Dans le cas d’une rénovation résultant d’une obligation (c’est-à-dire d’une mise en conformité), les travaux seront d’autant plus faciles à réaliser que seront réunis simultanément le financement et la garantie de résultat.

En l’absence d’obligation, c’est l’envie qui prévaut. Jusqu’à présent, les deux déclencheurs imaginés pour la susciter ont été la peur (la planète se réchauffe) et le gain économique (réduction de la facture énergétique).

Aujourd’hui, la situation a bien changé : le dérèglement climatique est une réalité avérée mais trop éloignée des préoccupations quotidiennes. Quant à l’énergie, son prix est à un niveau particulièrement bas.

D’autre part, la rénovation énergétique a été plus pensée comme un objectif de politique énergétique que comme une réalité économique. Or, sans marché, les professionnels du bâtiment, à quelques exceptions près, n’ont pas cherché à investir dans le domaine de la rénovation énergétique. Dans le même temps, faute d’offre attractive, les consommateurs n’ont pas eu de quoi alimenter un marché.

C’est donc tout le processus de vente de la rénovation énergétique qu’il faut reprendre, ou plutôt, initier.

Cela commence par considérer la rénovation comme un service marchand, et non comme un objectif politique.

En premier lieu, il conviendra de définir son positionnement, qui n’est pas le même s’il s’agit de rénovation, d’entretien ou d’amélioration. Utiliser le terme de « rénovation » pour ces différents cas de figure risque d’apporter de la confusion à des sujets déjà complexes par nature.

Puis, il faudra réaliser une véritable étude de marché de ce service. Cela permettra de connaître les envies ou attentes des consommateurs et le prix qu’ils seraient prêts à dépenser pour satisfaire leur besoin.

A partir de là, les entreprises et les pouvoirs publics pourraient bâtir une stratégie de vente. Les premiers en construisant le modèle d’affaire du service et en concevant les moyens de lui garantir qualité et meilleur prix. Les seconds en calculant la part d’aide qui devrait être apportée à ce service pour le rendre attractif en fonction des cibles visées.

2.2 Confort

Le confort est clairement un argument à mettre en avant. Par contre, il faudra savoir aller au-delà du seul mot et de définir les indicateurs permettant de mesurer l’amélioration de ce confort (température, humidité, qualité de l’air, bruit…)

2.3 Vieillissement

Le vieillissement de la population et plus largement le handicap et la dépendance sont clairement des obligations non choisies. L’argument peut s’entendre mais la charge négative qu’il porte n’aidera pas à elle seule à dynamiser le marché de la rénovation. Par contre, aider conjointement l’adaptation de ces habitats (monte-personnes, seuils abaissés, alarmes, barres de soutien…) à l’amélioration de leurs performances énergétiques serait un excellent déclencheur.

3. Comment coupler rénovation énergétique et confort ?

Les deux sujets sont liés : l’amélioration de la performance énergétique d’un logement participe au confort de ses occupants.

Coupler l’offre d’amélioration de confort et d’amélioration énergétique permettra de dynamiser l’ensemble. Il faut, pour cela, que tant l’offre que les aides soient également couplées.

4. Quels sont les leviers économiques pour créer une dynamique de rénovation plus forte ? Quels sont les enjeux pour la collectivité, les habitants et les filières professionnelles ?

L’Habitat est-il un bien de consommation ?

4.1 Leviers économiques

Dans une situation économique difficile, les travaux de rénovation et encore plus d’amélioration ne peuvent être portés sans aide par la plupart des ménages. D’autant que l’argument du remboursement des travaux de rénovation/amélioration énergétique par les économies d’énergie générées dans la durée est difficile à retenir, qui plus est depuis la très forte baisse du prix des énergies.

Partant du principe que les aides publiques ne devraient être attribuées qu’aux ménages en ayant le plus besoin, il faudrait les concentrer sur ceux 1) en situation de précarité ou de très faible ressource 2) habitant des logements énergivores.

Les programmes tels que le programme Habiter mieux de l’ANAH vont dans ce sens et les résultats qu’il obtient sont remarquables. L’augmentation récente des fonds qui lui sont alloués lui permettra de passer de 50 000 à 70 000 rénovations lourdes par an, et c’est tant mieux. Mais, ramenés aux 4,3 millions de ménages précaires, on voit l’ampleur de l’effort supplémentaire qu’il faudrait consentir.

Pour que le marché de la rénovation décolle, il faudrait, a minima, qu’existe une offre de qualité, c’est-à-dire garantissant les niveaux de performance énergétique pour un prix compétitif.

La seule façon de la faire émerger, en l’absence de marché naturel, est de générer, temporairement, un marché subventionné.

Les pouvoirs publics devraient concentrer leurs aides et subventions, hors précarité, au co-financement d’un nombre conséquent de travaux de rénovation portant sur des opérations reproductibles. Les bailleurs sociaux semblent tout indiqués pour identifier et proposer à la rénovation/amélioration des ensembles de logements de même nature, qu’ils soient individuels ou collectifs. A travers des consultations portant sur des lots cohérents de logements à rénover, les entreprises, ayant la vision concrète d’un marché, seront alors intéressées à concourir pour proposer des solutions de qualité et économiquement rentables.

Cet effet d’amorce permettra de construire l’offre qui fait défaut aujourd’hui. Couplée à l’étude des attentes des consommateurs, elle pourra enfin permettre le décollage du marché de la rénovation/amélioration énergétique.

4.2. Enjeux

Pour la collectivité et les habitants concernés, les enjeux sont d’abord sociaux, puis environnementaux. En plus des aspects de santé et de confort, disposer d’un logement décent, la première des aspirations de chacun, renforce la confiance que l’on peut avoir dans la collectivité.

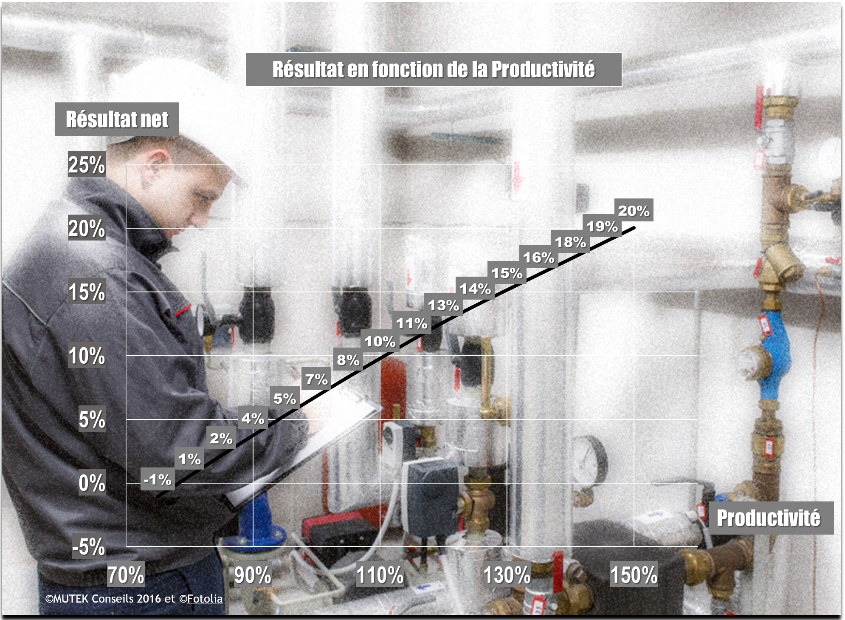

La dernière étude OPEN (données de 2013) sur les travaux de rénovation du parc privé, annonce un chiffre d’affaire de l’entretien-amélioration du logement de 40 milliards. 2,6 millions de logements ont conduit des travaux d’amélioration énergétique pour un montant de 12,8 milliards d’euros. 265 000 logements ont été rénovés « 3 étoiles » c’est à dire en visant un gain de performance comparable à celui des 500 000 logements à rénover par an, à compter de 2017, dont 380 000 dans le secteur privé.

En considérant comme acquis les 70 000 rénovations énergétiques du secteur social du programme Habiter mieux, ce sont 150 000 rénovations lourdes supplémentaires par an qu’il conviendra de mener pour atteindre l’objectif des « 500 000 ». A 30 000 euros la rénovation par logement, ces travaux permettraient de générer 4,5 milliards d’euros de chiffre d’affaire et de créer 40 000 emplois.

Les grands groupes étant peu enclins à s’adresser aux particuliers, ce nouveau marché sera principalement servi par des petites et moyennes entreprises et des artisans.

Ces derniers ont toutes les capacités pour répondre aux exigences de l’amélioration énergétique des bâtiments. Par contre, de par leur taille, ils sont plutôt spécialisés dans un voire deux domaines d’intervention, alors que l’amélioration énergétique et qui plus est l’amélioration du confort des logements réclament un traitement global. Au-delà des solutions de groupement, il sera essentiel que leurs travaux puissent être pilotés et coordonnées par des professionnels ayant la vision globale des enjeux et la connaissance des techniques mises en œuvre. Il s’agit de véritables assistants aux maîtres d’ouvrage, ces derniers étant en l’espèce les consommateurs et les ménages. Ce nouveau métier, entre maître d’œuvre, architecte et conseiller des Points Rénovation Info Service sera à créer, avec une compétence reconnue par un diplôme ou une formation certifiante, toujours dans le souci de donner confiance aux ménages.

4.3. Habitat, bien de consommation ?

Ce n’est pas l’habitat mais la rénovation de l’habitat qui est un bien de consommation et doit donc être traité comme tel.

Considérer la rénovation de l’habitat comme un produit de consommation, et non plus comme un objectif de politique énergétique, changerait complètement la posture aussi bien des offreurs que des demandeurs.

Cela inviterait les premiers à chercher à rendre leurs produits « vendables », c’est-à-dire porteur d’une valeur ajoutée perceptible par les clients potentiels.

Cela permettrait aux seconds d’être consultés sur leurs véritables attentes, sur leurs besoins et sur leurs priorités.

En résumer, les professionnels du bâtiment comme les pouvoirs publics pourraient avoir avantage à considérer la rénovation de l’habit comme un produit, un produit de consommation comme un autre, que l’on cherche à vendre dans un environnement concurrentiel.

5. Quels sont les nouveaux outils et les nouvelles dispositions à mettre en œuvre pour inciter les particuliers à rénover leur logement ?

S’agissant de ménages modestes ou en état de précarité, les travaux ne pourront se concevoir sans une aide massive des pouvoirs publics, en réalisation (conseil, suivi, garantie) comme en financement. Les subventions aux travaux telles qu’elles existent à l’ANAH répondent à ces besoins. Mais elles n’ont de moyens que pour aider 50 000 logements par an aujourd’hui et 70 000 demain. Il ne s’agit, ici, pas de récréer un outil qui marche mais bien d’en augmenter franchement les ressources financières.

A partir du moment où les professionnels du bâtiment seront en mesure de proposer une offre attractive, les particuliers sans problème de ressources, pourront réaliser des travaux.

Mais l’envie seule risque de ne pas être suffisante. Il faudra alors recourir à une obligation réglementaire. Celle-ci donnera un signal, tant aux acteurs du bâtiment qu’aux propriétaires. Cette obligation devra être progressive, modulée et inscrite dans une période de temps suffisamment longue pour permettre aux offres de qualité de se constituer. Elle devra être cohérente, ce qui suppose d’harmoniser les obligations des réglementations thermiques pour des bâtiments existants avec celles relatives aux bâtiments neufs. Enfin, elle devra être directement lisible par les occupants des logements à qui elle est destinée. En particulier, elle devra employer un vocabulaire compréhensible: les engagements de performance devront s’exprimer dans la même unité que celle qui sert à facturer l’énergie consommée.

Pour plus de détail sur le principe de cette obligation et ses avantages attendus, voir la contribution faite au Plan Bâtiment Grenelle en 2013 sur l’obligation de rénovation dans le logement : http://mutek-conseils.com/wp-content/uploads/2015/09/Pascal-JEAN-fiche-de-contribution-%C3%A9crite-explorer-lobligation-de-renovation-dans-le-secteur-residentiel.pdf

6. Quelles sont les spécificités de l’habitat individuel et celles de l’habitat collectif quant à la prise de décision de travaux ? Quels sont les contraintes et les leviers d’action ?

Contrairement à l’habitat individuel, ou au logement social, pour lequel les décisions sont prises par le seul propriétaire, l’habitat collectif demande l’accord de l’ensemble des copropriétaires dès l’instant où les travaux concernent les parties communes, ce qui est en général le cas s’agissant de rénovation.

La principale contrainte dans le logement collectif privé est le temps, les décisions devant se prendre en assemblée générale de copropriété, une fois par an. Un an pour décider si l’on fait un audit. Puis un an pour choisir l’auditeur. Puis un an pour analyser le résultat de l’audit et identifier les travaux. Et encore un an pour choisir l’entreprise qui réalisera les travaux. 5 ans, dans le pire des cas, s’écoulent entre le début de la démarche et le début des travaux. Le législateur a déjà facilité le mode de vote des travaux de rénovation énergétique. Il faut aller plus loin et imposer que les décisions se prennent au maximum en deux ans, via deux assemblées générales successives. La première permettra de choisir l’auditeur et le cahier des charges. La seconde, après présentation de ses conclusions par le comité des travaux, permettra de choisir l’entreprise de travaux, le cahier des charges et lancer les travaux.

Pascal JEAN – 22 avril 2016