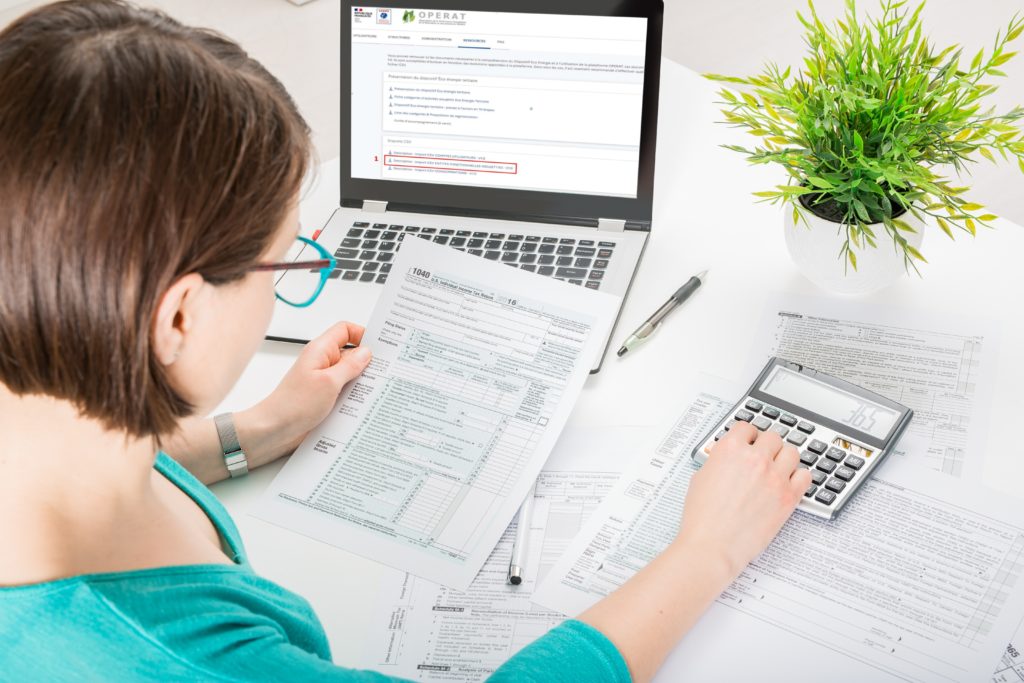

Avant le 30 septembre de cette année, le décret éco-économie d’énergie, que l’on appelait décret tertiaire, oblige les occupants ou détenteurs de locaux tertiaires de plus de 1000 m2 à renseigner la consommation de référence de leurs locaux dans un outil de l’administration, qui en appréciera l’évolution au fil du temps. S’agissant d’une première dont les règles ne sont pas encore finalisées, faut-il vraiment chercher à respecter cette échéance légale ?

Rappel de la loi

Le décret éco-économie d’énergie est une déclinaison de la loi ELAN de 2018. Il décrit l’obligation qu’ont les propriétaires et/ou locataires de locaux tertiaires de plus de 1000 m2, hors cas particuliers, d’en réduire la consommation énergétique. Soit, ils choisissent de le faire jusqu’à atteindre une valeur seuil, définie par arrêté, soit ils optent pour une diminution en pourcentages, se conformant à la règle mnémotechnique des « -40% en 2030, -50% en 2040 et -60% en 2050 ».

Dans les deux cas, s’agissant d’atteindre un objectif à partir d’une situation de départ, la première étape à franchir est de choisir quand démarrer. Pour pouvoir intégrer dans les réductions de consommations les travaux de rénovation énergétiques qui auraient déjà été engagés avant la prise d’effet de la loi, les propriétaires et/ou locataires, appelés assujettis, peuvent choisir leur point de départ entre 2010 et 2020, dès l’instant où ils peuvent justifier de 12 mois continus de consommation.

Des sanctions quasi inexistantes et pas avant… 10 ans

Le choix de cette année, dite de référence, ainsi que les conditions d’occupation et de fonctionnement des locaux à cette date, doivent être renseignés volontairement au plus tard le 30 septembre 2022.

La vérification du respect des réductions de consommation se fera tous les dix ans soit, au plus tôt, en décembre 2031 pour la première période. Quant aux sanctions pénales et/ou financières pour saisie hors délai des données demandées sur l’application OPERAT qui lui est destinée, il n’y en n’a pas… Dans ce cas, quel serait l’intérêt de chercher à respecter la date du 30 septembre 2022 ?

Rien ne sert de courir…

Plusieurs arguments vont dans ce sens. En premier lieu, ce délai pourrait être reporté d’un an, comme cela a déjà été le cas l’année dernière, l’outil OPERAT n’étant pas prêt et les valeurs de seuil par catégorie de bâtiment trop peu nombreuses. Ensuite, récupérer toutes les données patrimoniales, définir et faire accepter la répartition des tâches entre propriétaires et locataires, récupérer ses factures d’énergie, et/ou les données de consommations de 2010 à 2020, est un véritable travail de titan, surtout si l’on a changé de fournisseur d’énergie dans l’intervalle. En plus, il faut se doter de ressources, externes ou internes, pour réaliser le fastidieux travail de recensement de données éparses et incomplètes. Enfin, nul ne peut prédire de ce qu’il résultera de l’après élection présidentielle. Il est donc urgent d’attendre.

Faut-il prendre le risque ?

Mais est-ce un bon calcul ? Qui peut croire que l’objectif de réduction des consommations énergétiques des bâtiments puisse être supprimé, qui plus est quand la France présidera, jusqu’en juin 2022, le conseil de l’Union européenne dont la loi ELAN est issue ? Même si son application prend du retard et que les sanctions de non saisie ne sont que morales (principe du « name and shame ») quel est l’intérêt pour un propriétaire de montrer son peu d’entrain pour améliorer son bilan carbone et d’ainsi prendre le risque d’une forte dévalorisation de son image et de la valeur de son parc ?

Même si le législateur se montrera clément jusqu’en septembre 2023, reporter le lancement du recueil de données de consommations, c’est prendre le risque qu’elles ne soient plus disponibles. En effet, les fournisseurs d’énergie n’ont obligation de garder les factures de leurs clients que pendant 3 à 5 ans alors que les assujettis ont obligation de justifier leurs consommations. Se poser la question en 2023, c’est prendre le risque de se voir imposer comme année de référence l’année 2020. Or 2020 a été une année de faible consommation, du fait du COVID. L’OID a estimé cette baisse de consommation de 10%. C’est-à-dire que la consommation de référence du bien sera sous-évaluée d’autant. Pour un calcul en pourcentage, qui représentera environ 60% des cas d’après l’OID, les propriétaires et locataires devront faire plus d’efforts que s’ils avaient pu choisir une année de forte consommation ramenée aux conditions climatiques.

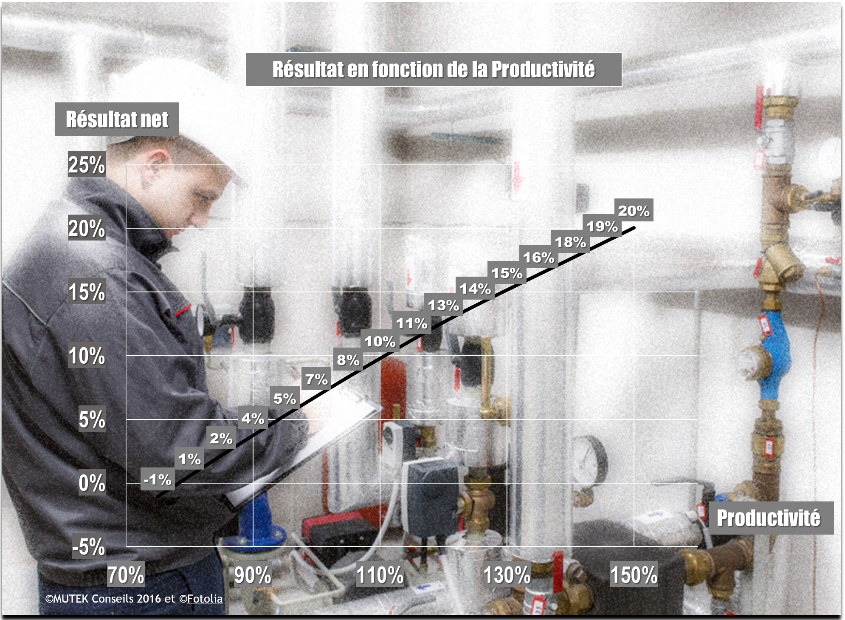

10%, cela peut paraître peu, mais c’est bon an mal an le pourcentage de gains énergétiques qu’un propriétaire peut obtenir avec très peu de dépenses, en agissant uniquement sur le comportement des usagers.

Alors qu’il aurait pu se « contenter » de réaliser des travaux pour aboutir à une baisse de 40% de ses consommations en 2030, il devra finalement engager encore plus de moyens pour atteindre les 50% de réduction. En 2040 cela passera à 60% et en 2050 à 70% !

Même si on évite de se faire imposer 2020, ne pas se donner le temps de choisir soigneusement son année de référence, par exemple en retenant intuitivement l’année de plus forte consommation, sera tout autant préjudiciable.

En effet, le choix de l’année de référence ne peut se limiter aux seules consommations d’un bâtiment mais doit se faire en connaissance de ses conditions d’usage et de la dynamique patrimoniale du parc dont il fait partie. Ce travail de recueil et d’analyse prenant du temps, il s’agira de ne pas se laisser déborder.

De combien parle-t-on ?

Les études chiffrées sont malheureusement peu nombreuses et difficiles à interpréter tant les situations sont différentes et qu’il est délicat d’identifier, dans une rénovation globale, la part uniquement dédiée à l’économie d’énergie. Mais on peut avoir en tête les ordres de grandeur suivants : le surcoût de rénovation énergétique pour atteindre une diminution de 10 à 30% va de 0 à 100 euros par m2. Pour ce faire, on agit sur les comportements, l’exploitation et quelques remplacements d’équipements peu coûteux. Pour atteindre une économie de 30 à 40%, on dépense de 100 à 200 euros par m2 en remplaçant, en plus des actions précédentes, les équipements de production de chaleur ou de froid voire en commençant à isoler. Pour atteindre 50% de réduction, le coût passe à 200 €/m2. Au-delà, tout peut se concevoir, dès l’instant où l’enveloppe, la ventilation et les systèmes de production énergétiques sont impliqués. Les prix au m2 vont alors de 300 à 750 € le m2. D’autres retours d’expérience affichent même des coûts de rénovation dépassant facilement les 1 000 euros par m2.

Tout ceci se traduit en dizaines de milliers, voire en millions d’euros, somme dont une grande partie aurait pu être facilement économisée.

Il faut partir à point

Propriétaires, locataires, il est donc plus que temps de vous mettre en ordre de marche. Et surtout, de transformer ce qui peut vous paraître une contrainte en atout. Vous avez sûrement déjà engagé des actions vous permettant de mieux connaître votre patrimoine et sa consommation, comme un bilan carbone, une normalisation de type ISO 14000 ou 50000, l’écritures de baux verts… Même si vous n’avez pas une vision exhaustive et complète de votre parc vous avez au moins de quoi commencer à alimenter OPERAT pour répondre à vos obligations. Pour la première année, le législateur a déjà prévu d’être indulgent. Profitez-en !

Une fois ces questions de recueil d’informations derrière vous, vous pourrez alors vous consacrer à ce qui compte vraiment : améliorer les performances énergétiques de vos bâtiments. La planète, vos locataires et votre portefeuille (meilleure valorisation du parc et diminution de son taux de vacance) ne s’en porteront que mieux.

Vous avez donc tout à y gagner. Mais s’il vous plait, n’attendez pas le dernier moment. Sinon, gare aux mauvaises surprises !

Pascal JEAN

MUTEK conseils

Sources :

www.ademe.fr