La prise de conscience climatique

Le 21 mars 1994, est entré en vigueur la Convention-cadre des Nations Unies contre le Changement Climatique (CCNUCC), ou Convention de Rio. Elle reconnaissait, pour la première fois au niveau mondial, l’existence et les impacts des changements climatiques. L’objectif ultime de cette convention était de stabiliser les concentrations de gaz à effet de serre “à un niveau qui empêcherait toute perturbation anthropique dangereuse du système climatique”.

S’en est suivi en 1997 le protocole de Kyoto, qui a traduit en chiffres les déclarations d’intention de la CCNUCC : 37 pays industrialisés et l’Union européenne se sont alors engagés à réduire leurs émissions de CO2 de 5% par rapport au niveau d’émissions de 1990, sur la période 2008-2012.

Puis le protocole de Doha a renforcé en 2012 cet engagement avec un objectif de réduction de 18% de 2013-à 2020.

Mais il a fallu attendre le 12 décembre 2015 et l’accord de Paris (COP 21) pour qu’un engagement sur le long terme soit enfin pris, à savoir celui de « contenir l’élévation de la température moyenne de la planète nettement en dessous de 2 °C par rapport aux niveaux préindustriels et de poursuivre l’action menée pour limiter l’élévation des températures à 1,5 °C ».

Pour quel résultat

Mais cette limite a déjà été atteinte : +1,45°C ont été enregistrés le 19 mars 2024 pour l’année 2023.

Quant à l’objectif pris à partir des études de 2007 (voir tableau), de baisser d’ici 2050 de 50% les émissions du globe dont 75% des émissions des pays industrialisés (Facteur 4), pour ne pas dépasser +2,4°C et +2,8°C d’augmentation de température d’ici la fin du siècle, il a peu de chance d’être tenu, les émissions mondiales de CO2 d’origine fossile n’ayant cessé d’augmenter bien plus vite que les puits de carbone.

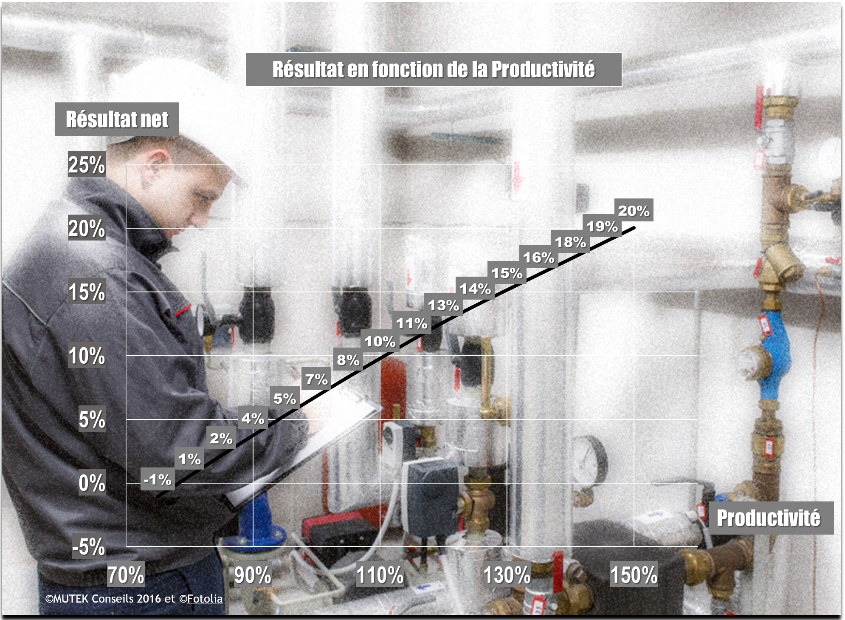

Scénarios d’augmentation de la température du globe en fonction des efforts de réduction de CO2 à réaliser

| Augmentation prévisible de la température globale moyenne par rapport à l’ère préindustrielle | Année estimée du pic d’émission | % de réduction de CO2 à consentir d’ici 2050 pour atteindre ce résultat | Nombre de scenarios ayant conduit à ces hypothèses |

| +2,0 à +2,4°C | 2000-2015 | -50 à -85% | 6 |

| +2,4 à +2,8 °C | 2000-2020 | -30 à -60% | 18 |

| +2,8 à +3,2 °C | 2010-2030 | +5 à -30% | 21 |

| +3,2 à +4,0°C | 2020-2060 | +10 à +60% | 118 |

| +4,0 à +4,9°C | 2050-2080 | +25 à +85% | 9 |

| +4,9 à +6,1°C | 2060-2090 | +90 à +140% | 5 |

| Total | 117 |

Pour la France, comme pour toutes les terres émergées qui se réchauffent plus vite que les océans, les scénarios actuels les plus optimistes prévoient une élévation moyenne de température de +3,8°C à +4,5°C.

Tempêtes, inondations, vagues de chaleur et sécheresses vont donc augmenter en force et en fréquence.

Tous les secteurs seront concernés et en particulier celui du bâtiment dont le but premier reste de garantir des conditions de vie et de travail sécures.

Pour qu’il le reste, il est donc nécessaire de l’adapter à la nouvelle donne climatique en prenant des mesures préventives.

Savoir, prévoir, informer

La première des actions à mener est de réaliser des diagnostics pour évaluer l’exposition au risque des bâtiments en fonction de leur localisation et de leur mode constructif.

Il s’agit de se renseigner sur l’état des sols, sur la vulnérabilité aux inondations, à la circulation des flux d’air et aux submersions marines.

On pourra utilement se référer à des outils tels que Géorisques, RARE (Resilience for Real Estate) de l’ Observatoire de l’Immobilier Durable (OID) ou encore à Vigicrues.

On pourra également visualiser une éventuelle déformation de la structure ou des fondations en posant des jauges mesurant les ouvertures de fissures et les contraintes.

Forts de ces informations, les gestionnaires de bâtiment seront en mesure de concevoir la meilleure stratégie de contournement pour limiter les dégâts face aux risques identifiés et, au passage, réduire le montant des primes d’assurance.

L’une d’elles consiste à identifier des lieux alternatifs où l’activité pourrait se poursuivre, dans le cas où le bâtiment serait endommagé ou rendu inaccessible. Pour les activités de bureaux, on pourra, comme il est procédé aujourd’hui pour d’autres raisons, déporter l’activité de l’entreprise chez l’employé (télétravail) ou dans un tiers lieu (coworking). Cela supposera de disposer d’un réseau informatique robuste, gérable à distance et protégé des cyberattaques.

Dans le cas où le risque deviendrait permanent (montée inexorable des eaux par exemple), il n’existera d’autres solutions que de transférer l’activité en un lieu moins exposé, en prévoyant également les conditions de transfert et d’accès des salariés.

Dans le même esprit, il conviendra de prévoir les moyens de protéger les occupants et les matériels, en se dotant d’équipements de sécurité et de secours, de zones refuges équipées en eau voire en nourriture et de zones de repli vers des lieux accessibles à des soutiens extérieurs.

Des exercices et simulations devront être faits régulièrement pour vérifier, entre autres, la réactivité des occupants et la pertinence de l’organisation comme de la signalétique.

La troisième action à mener, une fois le diagnostic de situation réalisé et les solutions de repli élaborées sera de communiquer le résultat des réflexions et les solutions envisagées aux occupants des bâtiments.

La communication est essentielle pour se préparer au mieux et adopter les bonnes attitudes face aux menaces.

Il faudra veiller à éviter les communications contreproductives car à contre-temps ou non adaptées au lieu et privilégier les exemples concrets aux discours généraux trop alarmistes. L’accent devra être mis sur les solutions plus que sur les problèmes, sans toutefois les nier.

Le végétal, meilleur rempart naturel

La végétation autour, sur et dans les bâtiments offre de nombreuses réponses adaptations aux aléas climatiques, sans parler de leur pouvoir déstressant.

En façade comme en toiture, leur double pouvoir rafraîchissant et isolant permet de réduire les besoins en climatisation et chauffage.

Par forte chaleur, les végétaux créent de l’ombre, directe et portée, et redéployent l’humidité du sol par évapotranspiration. Ainsi, ils permettent de baisser les températures et les besoins en refroidissement. Ils protègent également les équipements des ardeurs du vent pour lesquels ils sont autant de barrières naturelles.

Enfin, en cas de fortes pluies, ils facilitent l’absorption de l’eau et réduisent ainsi l’intensité des inondations.

Si cela est possible, on peut aller plus loin dans l’aide à l’infiltration de l’eau dans les sols en désimperméabilisant les aires de stationnement ou les abords goudronnés des bâtiments, ce qui revient à renaturer les sols, à l’échelle d’un bâtiment, selon le concept de « ville éponge ».

Il faudra toutefois bien veiller au choix des plantes pour qu’elles résistent aux évènements climatiques et arbitrer entre les essences méditerranéennes économes en eau mais peu rafraîchissantes et celles qui consomment plus d’eau mais qui, en échange, offrent une plus grande évapotranspiration. Pour économiser les apports d’eau, on préfèrera une façade végétalisée à un mur végétalisé.

Le législateur s’est déjà emparé du sujet : la loi Energie-Climat du 8 novembre 2019 oblige l’installation d’un système de végétalisation (ou de panneaux solaires) sur 30% de la surface de toiture des nouveaux entrepôts et bâtiments commerciaux et des ombrières de stationnement, tandis que l’arrêté du 19 décembre 2023 définit les caractéristiques minimales que doivent respecter les systèmes de végétalisation installés en toiture.

Réorganiser le positionnement des équipements

Face au danger de montée des eaux, la première des actions est d’élever, si possible, les équipements et matériels essentiels au fonctionnement du bâtiment.

Les rez-de-chaussée et encore plus les sous-sols serviront surtout de stockage ou de stationnement, les activités stratégiques pour l’entreprise étant montées en étage. Les réseaux d’énergie, de sécurité et de communication devront être compartimentés pour que la panne de l’un d’eaux n’empêche pas le fonctionnement d’un autre.

En réponse aux tempêtes, la bonne attitude est de répertorier tous les éléments fixes ou mobiles qui pourraient être endommagés ou emportés.

Pour les premiers (antennes, drapeaux, signalétique, bornes de recharge , volets, ombrières…), il faudra s’assurer que leur installateur a bien intégré la rigueur des climats futurs dans ses calculs de résistance au vent.

Pour les seconds (mobiliers extérieurs), il faudra faire preuve de bon sens, en cherchant d’abord à les fixer solidement ou, à défaut, les mettre à l’abri. Dans tous les cas, il conviendra de concevoir une procédure de sauvegarde sous la responsabilité de personnes préalablement désignées et formées pour le faire.

Utiliser des matériaux adaptés

Pour réduire la perte d’exploitation après une inondation, du fait d’une remise en état du second œuvre, on peut judicieusement choisir des matériaux résistant à l’eau pour les niveaux inondables. Pour les planchers, on privilégiera le béton plutôt que le bois ou la moquette, tandis que pour les cloisons et les menuiseries, on choisira des menuiseries en PVC et des cloisons sur ossature métalliques.

Enfin, pour réduire les besoins en refroidissement, on peut augmenter l’albédo des bâtiments, c’est-à-dire la part de rayonnement solaire qu’ils renvoient vers l’atmosphère, en choisissant pour leur enveloppe des couleurs claires ou des matériaux réfléchissants.

Choisir des solutions passives

Plutôt que de chercher à rafraîchir les locaux par des systèmes de climatisation très énergivores et qui ne font que déplacer le problème sans le régler (en climatisant, on produit toujours plus de chaud que de froid), on aura tout intérêt à profiter du rafraichissement diurne, de manière totalement passive.

On peut aussi faire baisser efficacement la température perçue par le corps humain (jusqu’à – 3°C) et créer une sensation de bien-être, en brassant l’air avec des plafonniers et autres ventilateurs.

On peut également installer des points d’eau créant des ilots de fraîcheur, sous forme de jets d’eau, fontaines ou brumisateurs (utilisant de l’eau de récupération). Leur effet dépassant rarement la dizaine de mètres, ces espaces fraîcheurs, seront de préférence à positionner dans des lieux d‘attente.

Agir maintenant

La bonne nouvelle est que toutes ces solutions existent et qu’elles ont déjà été mises en œuvre avec succès. Et que, contrairement à la chasse mondiale au CO2, chaque action menée localement aura un effet positif immédiat et directement visible.

Aux gestionnaires de bâtiment de s’en saisir, sans plus attendre.